剛剛過去的周(zhōu)末,光伏、儲能行業迎來重磅利好(hǎo)消息:摩根士丹利調高寧德時代目標價,在黃仁勳、奧特曼兩位大(dà)佬加(jiā)持下(xià)“儲能與AI”的故事發酵。

圖片(piàn)來源網絡

摩根士丹利調高寧德時代目標價

3月10日,摩根士丹利發布報告,將中國電池巨頭寧德時代(CATL)的評級上調至“超配”,並設(shè)定目標價為210元人民(mín)幣。在報告中,摩根士丹利分析(xī)師指出,寧德時代作為全球(qiú)領先的電池製(zhì)造商,受益於電動汽車市場的快速增長和電(diàn)池需求的攀升。

摩根士丹利發布(bù)報告指出,隨著價格戰(zhàn)接近尾聲,寧德時代準備通過新一(yī)代大規模生產線提高成本效率,並擴(kuò)大在淨資產收益率方麵的優勢,看到寧德時(shí)代在基本麵上的多個拐(guǎi)點,上調公司評級至超配,並選為行業首(shǒu)選。

另外,據央視網10日報道,寧德時代董事長曾毓群(qún)在采訪時談(tán)到了近期多家歐美車企削減或推遲(chí)電動化的話題,“歐美車企(qǐ)沒有回歸燃(rán)油車,也(yě)沒有停止(電動汽車),可能(néng)是因為不賺錢,所以往後延遲一陣(zhèn)。”

從儲能業務(wù)來看,寧德時代(dài)是當之無愧的王者。國海證券預計,該公司2023年動力和儲能電池的出貨量達(dá)380GWh以上,同比增長31%以上。單2023年四季度(dù)看,公司的出(chū)貨量達110GWh以上,同比增長(zhǎng)14%以(yǐ)上,環比增長(zhǎng)10%以上。按四季度中值計算,假(jiǎ)設公司的電(diàn)池業務利潤貢獻在90%,則(zé)測算公司單Wh盈利在1毛左右,與公司2023年前三(sān)季(jì)度的單位盈利基本保持相當。

黃仁勳、奧特曼:AI的盡頭是光伏和儲能

消息麵上,在算(suàn)力(lì)爆炒(chǎo)之後,“儲能+AI”的故事在剛剛過去的這個周末發酵了(le)。據報道,英偉達CEO黃仁勳在一次公開演講中指出,AI未來發展與狀和儲能緊密(mì)相連。黃仁勳在演講中(zhōng)明確表示:“AI的盡頭是光(guāng)伏和儲能!我們不能隻想著算力,如果隻考慮計算機,我們需要燒掉14個地球的(de)能源。”

早在2月27日,就有人在社交視(shì)頻上講“儲能與(yǔ)AI”的故事,引用的也是所謂“黃仁勳的演講”。與此同時,OpenAI的創始人(rén)山姆·奧特曼也提出了類似的看(kàn)法。奧特曼(màn)表示,“未(wèi)來AI的技術取決於能源,我們需要更多的光伏和儲能。”

ChatGPT日耗電超50萬度

人工智能技術的快速發展,帶來了巨大(dà)的算力和能源消耗。據《紐(niǔ)約客》雜誌報道(dào),ChatGPT日耗電超50萬度,相當於1.7萬個美國家庭,以響應用戶的約2億個請求。

*近,在博世互聯2024大會上,馬斯克遠程連(lián)線接受了博世CEO和(hé)董事長的采(cǎi)訪。馬(mǎ)斯克提(tí)到人工智能的發展速度前所未見,似(sì)乎每過(guò)6個月的時間,算力就會增加10倍,遠遠超出了(le)摩爾定律每18個月翻番(fān)的速度。他預計,兩年內年將由“缺矽”變為“缺電”,而這可能阻礙(ài)AI的(de)發展。

“目前算力增(zēng)長已經麵臨瓶頸,很明顯(xiǎn),接下來變壓器會(huì)陷入短缺,緊接著就是電力,等到2025年,我們將沒有(yǒu)足夠的電力來運行所有的芯片。”馬斯克稱(chēng)。

事實上,馬斯克對電力短缺的擔憂也不(bú)是一天兩天了(le),此(cǐ)前曾(céng)多次公開強(qiáng)調解決日益(yì)增長的電力需求的緊迫性(xìng)。他認為,需要加快項目進度,以跟上不斷增長的電(diàn)力需求。

我國台灣地區4月電(diàn)價調漲箭在弦上,“電價工作小組(zǔ)”3月12日起將連開4場討論會。其中(zhōng)民生用電擬(nǐ)分三級距調漲,*小漲幅700度(或500度(dù))以下約漲5%,701~1000度約漲7%,1001度以上漲(zhǎng)約10%;產業(yè)用電依產業別分三級距調漲,但連二年用電成長、用電50億度以(yǐ)上(shàng)“超級(jí)大戶”以公司別來看,調幅(fú)*高上看近3成,台積電首當其衝;但用電衰退麵板、石化、鋼鐵,漲幅較小。4月電價方案平均漲幅在10~15%。

波(bō)士頓(dùn)谘詢(xún)公司就曾分析稱,預計2030年左右,美國數據中心的電力消耗將較2022年增長三(sān)倍,相(xiàng)當於電力(lì)總需求的7.5%,會大(dà)幅提升社會(huì)用電(diàn)量。

谘(zī)詢公司Grid Strategies也曾(céng)發布過一項研究,認為美國未(wèi)來(lái)五年的(de)年度電力需求增(zēng)長大約(yuē)在1.5%左右(yòu)。而根據EIA的數據,美(měi)國發電量近15年來才增加了不到3%。過慣了供需相對穩定日子的美國(guó)供電體係,和麵臨不少問題的電網,能否應對驟然增長的需(xū)求,尚有待觀(guān)察。

從儲能業務來看,寧德時代是當之無愧的王者。國海證券預計,該(gāi)公司2023年動力和(hé)儲能電(diàn)池的出貨量達380GWh以上,同(tóng)比增長31%以上。單2023年四季度看,公(gōng)司的出貨(huò)量達110GWh以上,同比增長14%以上,環比增長10%以上(shàng)。按四季(jì)度中值計算,假設公司的電池業務利潤貢獻在90%,則測算公司(sī)單Wh盈利(lì)在(zài)1毛左右,與公司2023年前三季度的單位盈利基本保(bǎo)持相當。

AI大模(mó)型下的液冷發展趨勢

摘要

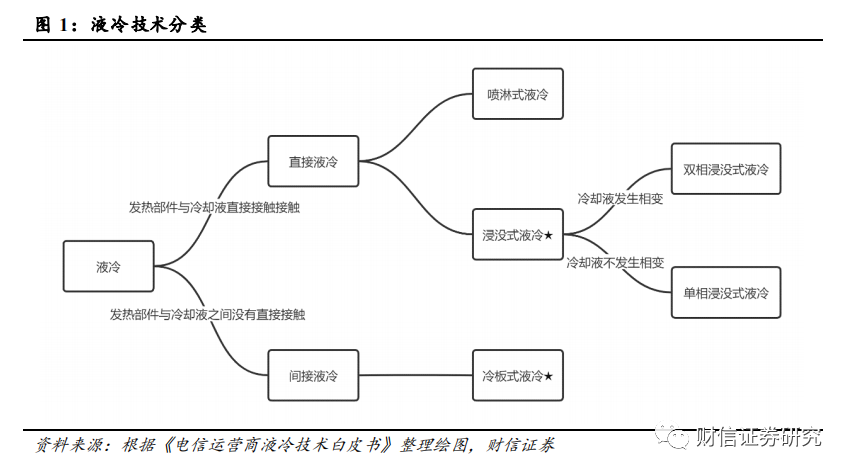

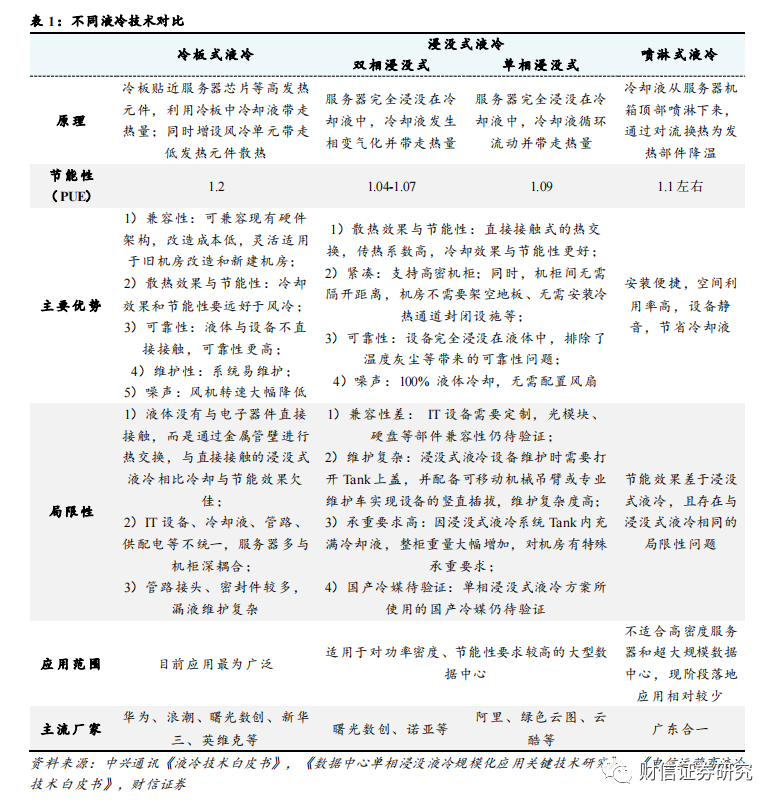

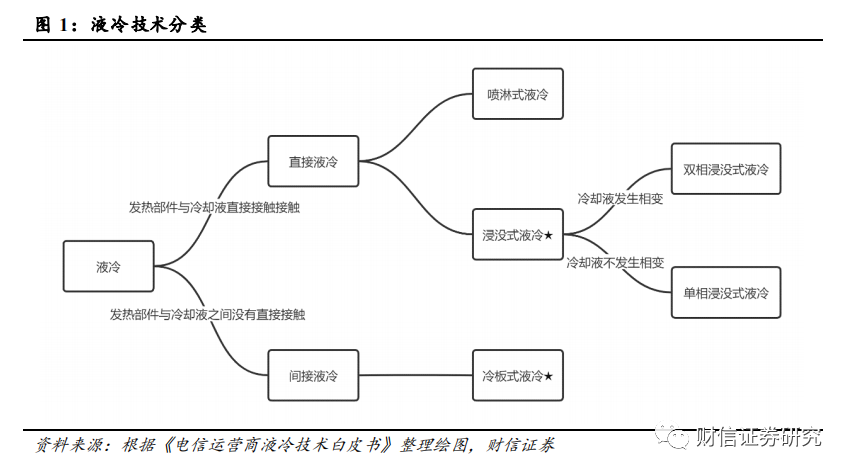

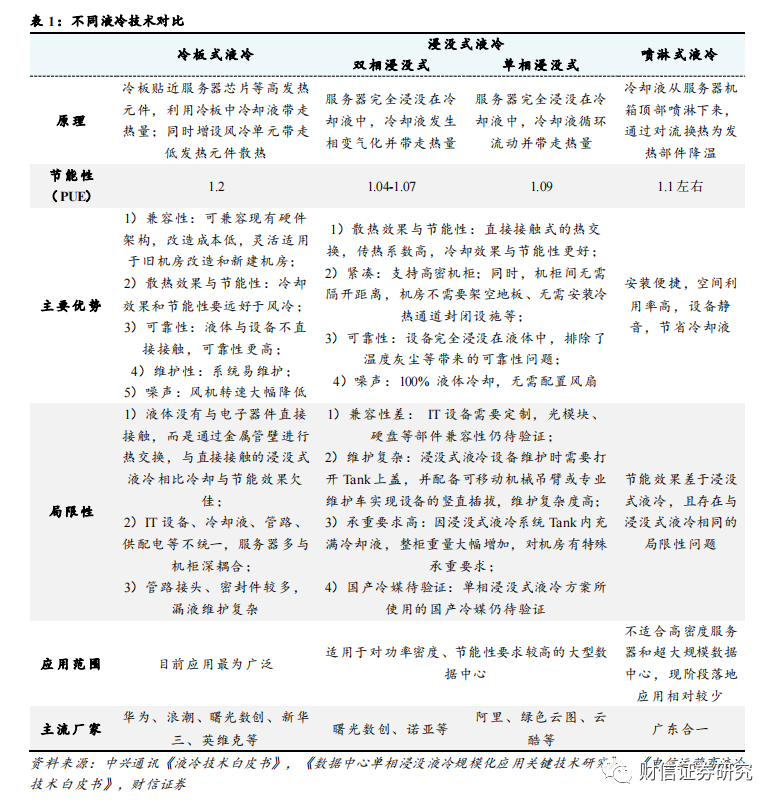

液冷(lěng)是一種用液體來冷卻電子設備的散熱技術,能夠顯著提高(gāo)數據中心散(sàn)熱效率。液冷(lěng)技術根據冷卻液與發熱器件的接觸方式不同,可以分為間接液冷和直接液(yè)冷,其中間接(jiē)液冷主要包括(kuò)冷板式液冷,直(zhí)接液冷包括浸沒式(shì)液冷和噴淋式液冷。冷板式液冷和浸沒式液冷是(shì)目前主流的液冷形式,冷板式(shì)液冷應(yīng)用*為(wéi)廣泛,在改造成本、可維護性、兼容性方麵(miàn)具備優勢;浸沒式液冷(lěng)冷卻效(xiào)果*好,節能性上優勢明顯,但可維護性和兼容性一般,多用於高功率密度機櫃。

控製當前數據中心溫控方(fāng)式仍(réng)以風冷為主,液冷方(fāng)案中冷(lěng)板式技術更為(wéi)普及。2022年數據中心液冷技術(shù)的滲(shèn)透(tòu)率(lǜ)大概在5%~8%左右,風冷(lěng)仍然占(zhàn)據90%以上(shàng)的市(shì)場份額。按照(zhào)服務器(qì)出貨量口徑(jìng)統計,2023H1我國冷板式液冷服務器(qì)比例為90%左右,浸沒式液冷滲透率(lǜ)為10%。

數據(jù)中心算力與能耗水漲船高,逐漸超出風冷散(sàn)熱閾值,液(yè)冷散熱已是趨勢所向。Chatgpt為代表的生成式人工智能模型拉升算力需求,百億參數成為模型湧現門(mén)檻,算力成為大模型性(xìng)能提升的關鍵。大模型帶來(lái)大算(suàn)力,大算力(lì)帶來(lái)高功耗(hào),Intel的多款CPU芯(xīn)片的TDP已突(tū)破350W,NVIDIA 的H100係列GPU芯片TDP更是達到700W。這也導致單服務器和(hé)單機櫃功率均顯著(zhe)上(shàng)升,已經逐漸超出風冷(lěng)散熱的覆蓋範圍(wéi),液冷散熱已成為必然趨勢。

PUE限製是現階段液冷技術(shù)發展的核心驅動(dòng)力(lì)。PUE代表數據中心能源使用效率,等於數據中心總耗電/IT設備耗電,比值越接近(jìn)於1,說明能源越(yuè)接近全部都用於IT設備(bèi)負載上。我國數據中心平均PUE為1.49,仍有半數區域的數(shù)據中心PUE位於1.5以上。近幾年,國家與地方出台了一係列針(zhēn)對新建與老舊數據中心PUE的(de)管控計劃,明確要求東、西部樞紐節點數據中心PUE分別(bié)控製在1.25、1.2以下(xià)。而傳統風冷方案的數據中(zhōng)心PUE一般在1.5左右,高(gāo)於(yú)政策要求(qiú)的(de)範(fàn)圍;液冷方案能夠有效降低冷卻係統的能耗水平(píng),從(cóng)而將數(shù)據中心整體(tǐ)PUE降低(dī)到1.05-1.2左右,滿足相關的政策要求。

數據中心TCO是液冷技術規模(mó)應用的關鍵因素。數據中心總成本(TCO)包括建(jiàn)設成本(Capex)和運(yùn)營成本(Opex)。根據(jù)奕信通(tōng)科技在2022年數據中心標(biāo)準峰會發(fā)布的報告進行測算,以華東地區數據中心建(jiàn)設情況為例,現(xiàn)階段冷板式液冷方案的(de)TCO甚至Capex已(yǐ)經低於風冷,浸沒式液冷方案的(de)TCO也將在運行五年左右之後出現低於風冷方案的拐點。但是該測算結果依(yī)賴於一定的前提條件:如機(jī)櫃功率達到30KW、不計算(suàn)服(fú)務器折舊和服(fú)務器運營支出、水電費與房租等運營成本按華(huá)東地區情況計價、采用集中式(shì)大型(xíng)IDC機房且IT設備在12個月線性上架後實現80%負載率、外界氣溫對製冷係統的能耗(hào)需求較高等。因此在西北部地區、較小型(xíng)數據中心等場(chǎng)景下液冷技(jì)術的經濟性尚沒有完全體現。但在數據(jù)中心發展的大型化、集約化的趨勢(shì)下,且液冷方案仍存在每年降本5-10%的(de)空間,再考(kǎo)慮到液冷方案(àn)能夠有效延長服務器使用壽(shòu)命,未(wèi)來液冷數據中心TCO的優勢將更加明顯。

控製數據中心液冷未來市(shì)場規模估算:到2025年,中(zhōng)國數據中心液冷市場規模將達(dá)到359億元左(zuǒ)右,CAGR達到72.4%;AI數(shù)據中心液冷市場規模將達到280億元左右,CAGR達到71.4%;通用數據中心液冷市場規模(mó)將達到79億元,CAGR達到76.2%。

1液冷技(jì)術(shù)詳解

液冷(lěng)是一種用液(yè)體來冷卻電子設備的散熱技術。液冷的工作原理是(shì)以液體作(zuò)為冷媒,利用液體的(de)高熱容和高熱(rè)傳導性能,通過液體流動將IT設備的內部元器件產生(shēng)的熱量傳(chuán)遞到設備外,使(shǐ)IT設備的發熱器件得(dé)到冷卻,以保證IT設備在安全溫(wēn)度範圍內運行(本文主(zhǔ)要討論數據中心應用場景下的液冷技術)。根(gēn)據冷(lěng)卻液與發熱器件(jiàn)的接觸方式不同(tóng),可(kě)以分為間接液冷和直接液(yè)冷。間接液冷是指服(fú)務器熱源與冷卻液之間沒有直接接觸(chù)的換熱過程,以(yǐ)冷板式(shì)液冷技術為主(zhǔ)。直接液冷是指將(jiāng)發熱部件與冷卻(què)液直接接觸的冷(lěng)卻方式,包括浸沒式和噴淋式(shì)液冷技術。其中又可以根據冷卻液是否會發生液態到氣態的轉變,將浸沒式液冷分為單相浸沒(méi)式液冷和雙相浸沒式液(yè)冷。當前(qián),冷板式液冷和浸沒式液冷為液冷的主要形式。

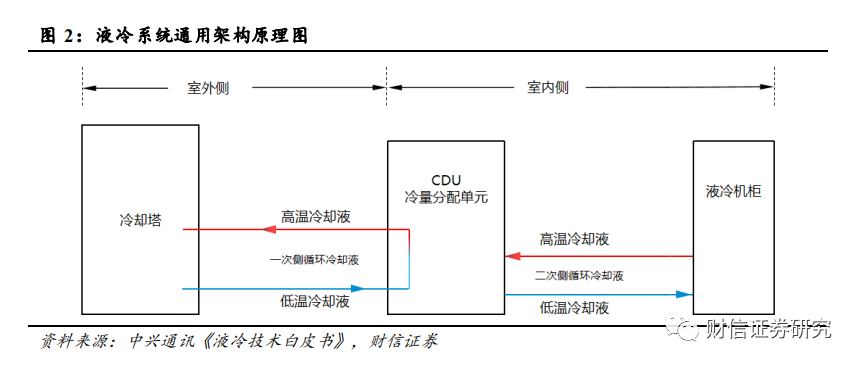

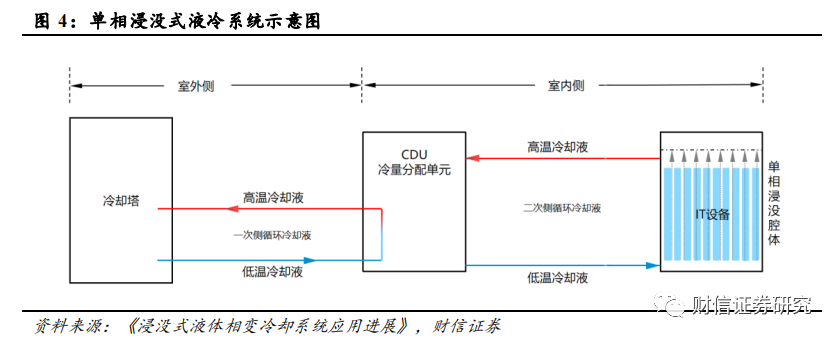

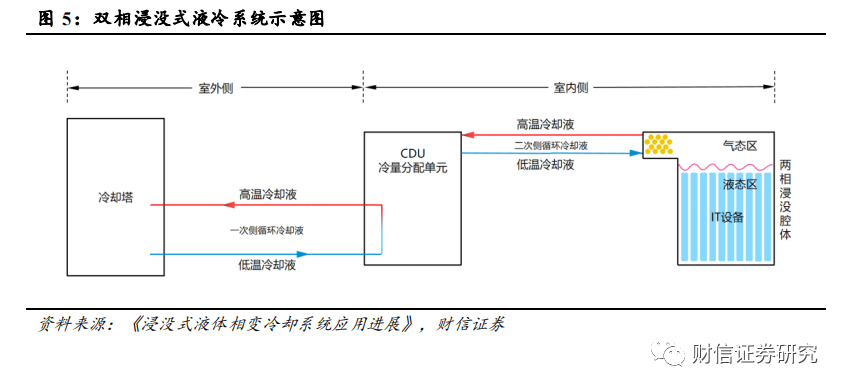

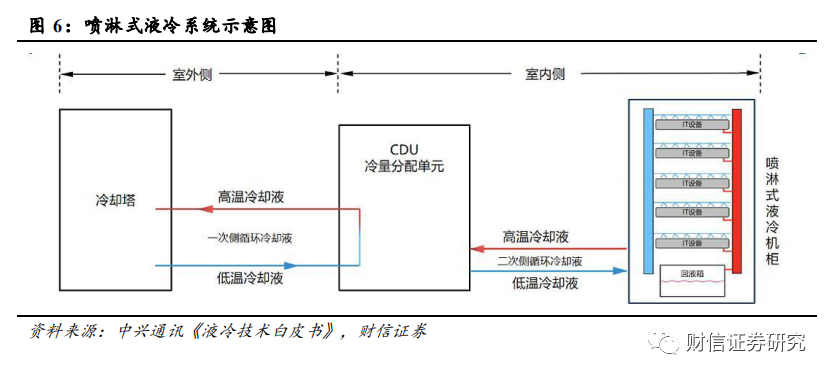

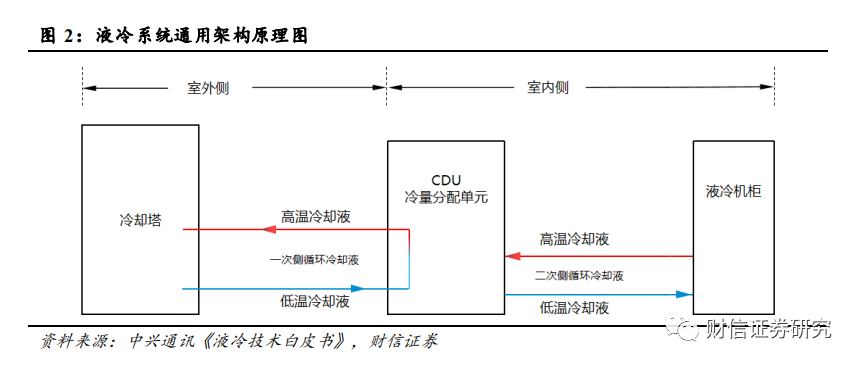

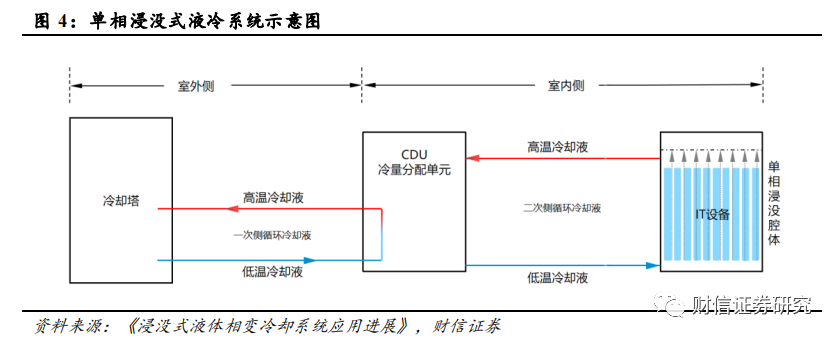

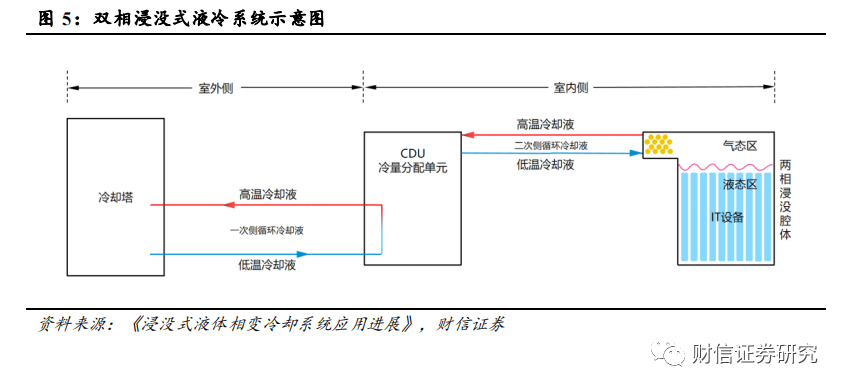

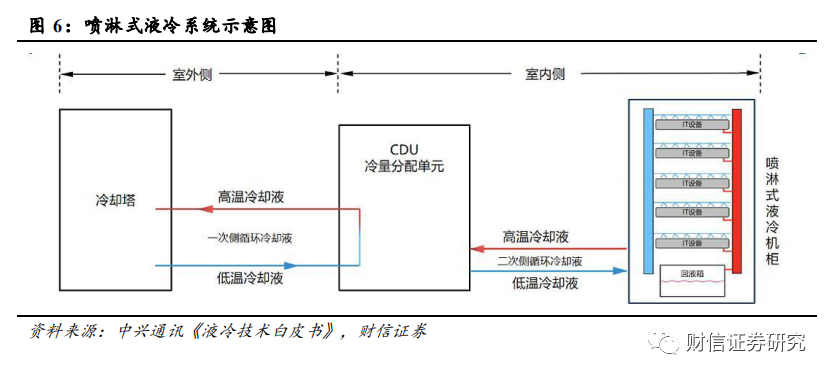

液冷係統通用架構包括(kuò)室外側和室內側兩部分:室外側包含冷卻塔、一次側管網、一次側冷卻液;室內側包含 CDU、液(yè)冷機櫃、ICT 設(shè)備、二次側管網和二次側冷卻液。室(shì)外側為外部冷源,通常為室外的冷水機(jī)組、冷卻塔或幹冷器,熱量轉移主要通(tōng)過水溫的升降實現;室內側包括供液環路和服務器內部流道,主要通過冷卻液溫度的升(shēng)降實現(xiàn)熱量轉移;兩個(gè)部分通(tōng)過CDU中的板式換熱器發生間壁(bì)式換熱。

1.1 冷板式液冷

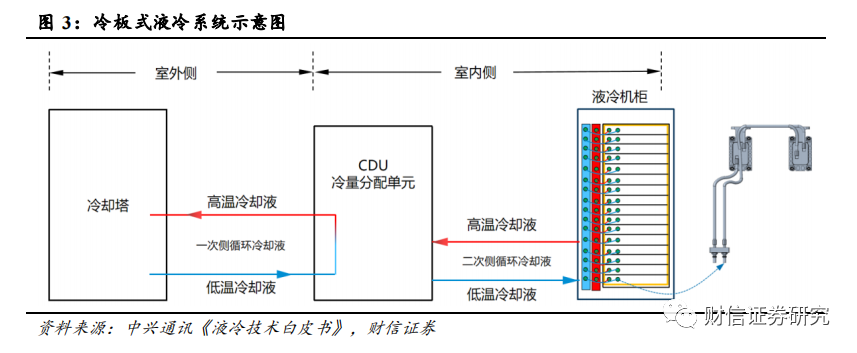

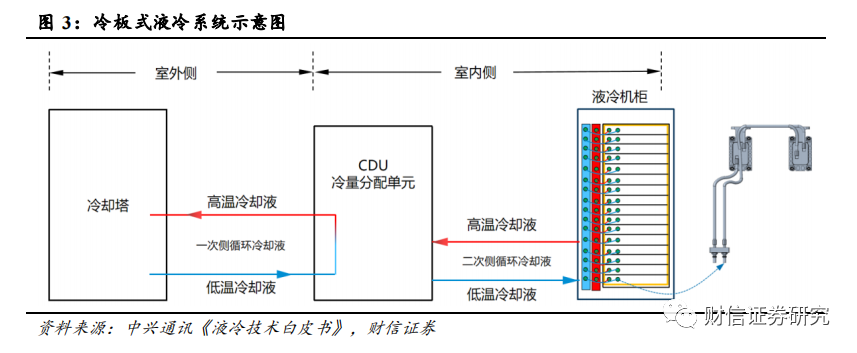

冷板(bǎn)式液冷屬於間接液冷,冷卻液不與服務器芯片直接接觸。冷板(bǎn)式液冷也被稱作芯片級液冷,技術原理是通過在服(fú)務器組件(如 CPU、GPU等高發(fā)熱部件)上安裝液冷板(通常為銅(tóng)鋁等導熱金屬構成的封閉腔(qiāng)體),服務器組(zǔ)件通過(guò)導熱部(bù)件(jiàn)將熱量傳導到液冷板上,然後利用液冷板(bǎn)內部的(de)液體循環將(jiāng)熱量傳遞到遠離服務器(qì)的散熱單元;同時一般會增設風冷單元為低發熱元件進行散熱。

冷板式液冷係統主(zhǔ)要由冷卻(què)塔、CDU、一次側 & 二次側液冷(lěng)管路(lù)、冷卻介質、液冷機櫃組成;其中液(yè)冷(lěng)機櫃(guì)內包含液冷板、設備內(nèi)液冷管路、流體連接器、分液器等。

1.2 浸沒式液冷

浸(jìn)沒(méi)式液冷屬於直接液冷,將發熱器件浸沒在冷卻液(yè)中進行熱交換,依靠冷卻液流動循環帶(dài)走熱量。

浸(jìn)沒式液冷係統室外側包含冷卻塔、一次側管網、一次側冷卻(què)液;室內側(cè)包含 CDU、浸沒腔體、IT 設備、二次側管網和二(èr)次側冷卻液。使用過程中 IT設備完全(quán)浸沒在二次側冷卻液中,因此二次側循環(huán)冷卻液需要采用不導電液體,如(rú)礦物油、矽油、氟化液等。

浸沒式液冷根據冷卻液換熱(rè)過程中是否發生相變,可(kě)以進一步分為單相(xiàng)浸沒式(shì)液(yè)冷和雙(shuāng)相浸沒式液冷技術。

1.2.1 單(dān)相浸沒式液(yè)冷

在(zài)單相浸沒式液冷中(zhōng),冷卻液在(zài)熱量傳遞過程中僅發生溫度變化(huà),而不存在相態轉變(biàn)。單相浸沒式液冷的技術原理為:CDU循環泵驅動二次側低溫冷卻液(yè)由浸沒腔體底部進入,流經豎(shù)插在浸(jìn)沒腔體中的IT設備時帶走發熱器件熱量;吸收熱量升溫後(hòu)的二次側冷卻液由浸(jìn)沒腔體頂部出口(kǒu)流回CDU;通過CDU內部的板式換(huàn)熱器(qì)將吸收(shōu)的熱(rè)量傳遞給一次(cì)側冷卻液;吸熱升(shēng)溫後(hòu)的一次側冷(lěng)卻液(yè)通過外部冷卻裝置(如冷卻塔)將熱量排放到大氣環境中,完成(chéng)整個冷卻過程。

1.2.2 雙相浸(jìn)沒(méi)式液冷

雙(shuāng)相浸沒式液冷的不同之處在於冷卻液會(huì)發生相態轉變。雙相浸沒式液冷的傳熱(rè)路徑與單相浸沒液冷基本(běn)一致,主要差異在於二次(cì)側冷卻液僅在浸沒腔體內部循環(huán)區域,浸沒(méi)腔(qiāng)體內頂部(bù)為氣態區、底部為液(yè)態區;IT設備完全浸(jìn)沒在低沸點的液態冷卻液中,液態冷卻液吸收設備熱量後發生沸騰,汽(qì)化產生的高溫氣態冷卻液因密度較小,會逐漸匯(huì)聚到浸(jìn)沒腔體頂部,與安裝在頂部的冷凝器發生換熱後冷凝為低溫液態(tài)冷卻(què)液,隨後在重力作用下回流至腔體底部(bù),實現對(duì)IT設備的散熱。

1.3 淋式液冷

噴(pēn)淋式液冷屬於(yú)直接液冷,將冷卻液精(jīng)準噴灑(sǎ)於電子設備(bèi)器件進行散熱。冷卻液借助特製的噴淋板精準噴灑至(zhì)發熱器(qì)件或與之相連接的固體導熱材料上,並與之(zhī)進行熱交換,吸熱後的冷卻液換熱後將通過回液管、回液箱等(děng)集(jí)液裝置進行收集並通過循環泵輸送至CDU進行下一次製冷循環。

噴淋式液冷係(xì)統主要由冷卻塔、CDU、一次側(cè) & 二次側液冷管(guǎn)路、冷卻介質和噴淋式液冷機櫃組成;其中噴淋式液冷機櫃通常包含管路係統、布(bù)液係統、噴淋模塊、回液係統等。

1.4 不同液冷方(fāng)案的比較

1.4.1 冷板式液冷(lěng)目前應用*為廣(guǎng)泛,在改造(zào)成本、可維護性、兼容性方麵具備優勢

冷板(bǎn)式液冷的優勢主要在於:

1)兼容性:冷板式液冷的改造成本相對較低,不(bú)需(xū)要對數據中心現有的機房及機(jī)櫃進行大規模改造,其適用的(de)硬盤、光模塊等服務器部件與風冷方案一致,運維模(mó)式、機房承重與風冷場景也基本一致;

2)散熱效果與節能性:冷卻效果和節能性要遠好於風冷(lěng),PUE可以達到1.2左右;(據《綠色高能效(xiào)數據中心散熱冷卻技術研究現(xiàn)狀(zhuàng)及發展趨勢》數(shù)據顯示,風冷散熱下數據中心的 PUE 值通常在1.5左右)

3)可靠性:液體與設備不直接(jiē)接觸,可靠性更高;

4)維護性:易開展維護性設(shè)計,可實現在線(xiàn)維護方(fāng)案;

5)噪聲:風機轉速大幅(fú)降低,噪聲值可至 70dB 左右。

冷板式(shì)液冷的局限性主要在於:

1)液體沒有與電子器件直接接觸,而是通過金屬管壁進行熱交換,與直接接觸的浸沒式液冷相比冷卻與(yǔ)節能效果欠佳;

2)IT設備、冷卻液、管路、供配電(diàn)等不統一,服務器多與機櫃深耦合;

3)管路接頭、密封件較多,漏液維護複雜(zá)。

1.4.2 浸沒式液冷的(de)散熱效果和節能性優(yōu)勢明顯,但兼容性和維護性一般,多用於高功率密(mì)度機櫃

浸(jìn)沒式液冷(lěng)的優勢主要在於:

1)散熱效果與節能性:與(yǔ)冷(lěng)板式液(yè)冷相比(bǐ),浸沒式液冷中采用了直接接觸式的(de)熱交換,傳熱係數(shù)高,冷卻效果(guǒ)更好,節能性更(gèng)強(雙相浸(jìn)沒式液冷方案的PUE在1.04-1.07左右,單相浸沒式為1.09左右)

2)緊湊:支持(chí)高密機櫃,單櫃散熱量高達160kW;同時,機櫃間無需隔開距離,機房不需要空調和(hé)冷凍(dòng)機組、無需架空地板、無需安裝冷熱通道(dào)封閉設施(shī);

3)可靠性:設備完全浸沒在(zài)液體中,排除了溫度、風(fēng)機振(zhèn)動、灰塵等帶來(lái)的可靠性問題;

4)噪聲:100%液(yè)體冷卻,無需配置風扇,實現**“靜(jìng)音”機房。

浸沒(méi)式液冷的(de)局(jú)限(xiàn)性主要(yào)在於:

1)兼容性(xìng)較差:IT設備需要定製,光模塊、硬盤等部件兼容性仍待驗證;此外,雙相浸沒式液(yè)冷方案(àn)適配的服務(wù)器(qì)需改為刀片式,其專用機(jī)櫃對(duì)於管路要求高,控(kòng)製複雜;

2)維護複雜:浸沒式液(yè)冷設備維護時需要打(dǎ)開Tank上蓋(gài),並配備可移動機械吊臂或專業維護車實現設備的豎直插拔,維護複雜度高,耗時長;且開(kāi)蓋維護過(guò)程(chéng)有一定的冷卻液揮發問題,增加運行(háng)成(chéng)本;

3)承重要求(qiú)高:因浸沒式液冷係統Tank內充(chōng)滿冷卻液,整櫃重量大幅增加,對(duì)機房(fáng)有特殊承重(chóng)要求,普遍要求浸沒(méi)式液冷機房地板承重應(yīng)大於(yú)1500kg/m2;

4)國產冷媒待驗證:單相浸沒式液冷方(fāng)案所使用的國產冷媒仍待驗證。

浸沒式液冷比較(jiào)適用於對功率密度、節能性要(yào)求較高的大型數(shù)據中心,特別是地理位置較為特殊、空間有限的數據中心。

1.4.3 噴淋式液冷在安裝便利性、空間利用等(děng)方麵有優勢(shì),但是現階段(duàn)落地應用相對較少(shǎo)

噴淋式液冷不需要對數據中心(xīn)基礎設施(shī)進行大幅改動,安裝便捷,空(kōng)間利(lì)用率高(gāo),且噴淋方式能夠節省冷卻液,其不足在於服務器整體密(mì)封於氣(qì)相櫃中,排液、補液(yè),維護時會破(pò)壞服務器原(yuán)有密封結構。目(mù)前噴淋式液冷技(jì)術的應用場景有限,隻有少量(liàng)數據中心采用了噴淋式液冷(lěng)技術。

2 數(shù)據中心(xīn)液冷行業基本情況(kuàng)與競爭格局

2.1 基本情(qíng)況:數(shù)據中心液冷行業如日方升,液冷(lěng)技術有望加速導入

數據中(zhōng)心溫控(kòng)方式仍以風冷為主,液冷(lěng)技術有望(wàng)加速導入。目前數(shù)據(jù)中心的散熱方式仍然以風冷為主,在算力設備以及數據中心機房的高熱密度趨勢和高(gāo)能效散熱要求的雙重推動下,預計未來液冷將成為主流的數據中心溫控方式。根據產業調研與曙光數(shù)創的信息,2022年數據中心(xīn)液冷技術(shù)的滲透率大概在5%~8%左右,風冷仍然占(zhàn)據90%以上的市場份額;預計2025-2028年時液冷技(jì)術的滲透率有望達(dá)到30%。

液冷方式以冷板式為(wéi)主,浸沒式技術有望(wàng)加(jiā)速推廣。當前主流的液冷技術包括冷板式液冷和浸沒式液冷,由於冷板式液冷對於(yú)數據中心的改造(zào)難度較低,改造所需成本也較為可控,所以目前冷(lěng)板式液冷(lěng)的市場應用相對更加普(pǔ)及(jí)。根(gēn)據IDC《中國半(bàn)年度液冷服務器市場(chǎng)(2023上半年)跟(gēn)蹤(zōng)》報告,按照服務器出貨量口徑統計,2023H1我國冷板式液冷服務器比(bǐ)例達到90%左右,浸沒式液冷(lěng)滲透率僅為10%。但隨著國家(jiā)對於數據中心PUE的政策要(yào)求的愈(yù)發嚴格,機櫃功率密度的持續抬升以及浸沒式液冷(lěng)技術的逐漸成熟,浸沒式液冷方案有望進入加速(sù)推廣期。

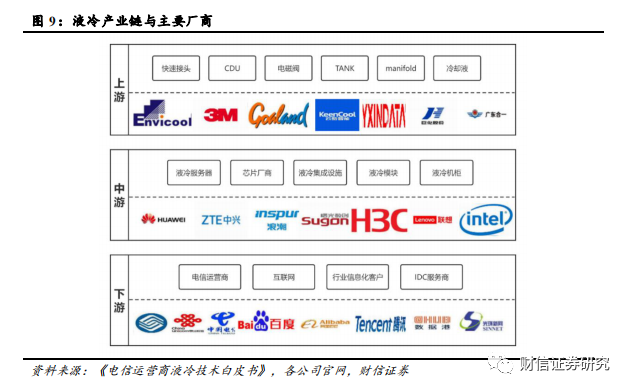

2.2 產業鏈:涉及環節眾多,存在較高進入壁(bì)壘

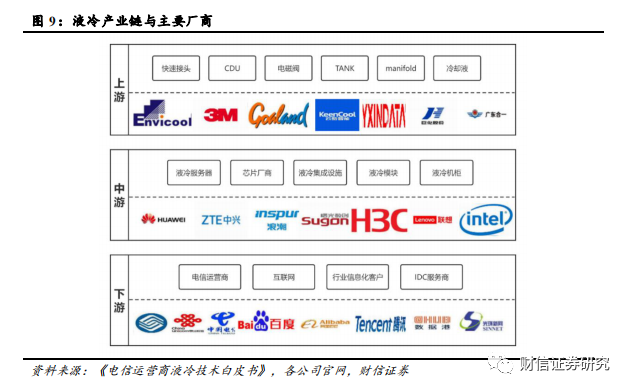

液冷產業(yè)鏈涉及環節眾多,包括上遊的液(yè)冷設備及產品零部件(jiàn)提供商、中遊(yóu)的液冷服務器及液冷(lěng)基礎設施提供(gòng)商與(yǔ)下遊的數據(jù)中心使用者。上遊主要為(wéi)產(chǎn)品零部件及(jí)液冷設備,包括快速(sù)接頭、CDU、電磁閥、浸沒液冷TANK、manifold、冷卻(què)液等產品,代表性(xìng)廠商有英維克、3M、高瀾股份、雲(yún)酷、奕(yì)信通、廣東合一、綠(lǜ)色雲圖、巨化股份等。中遊主要為液冷服務器、芯片廠商以及液冷集(jí)成設施、模塊(kuài)與機櫃等,代(dài)表性廠商(shāng)有華為、中(zhōng)興、浪潮、曙光、新華三、聯想、超聚變、英特(tè)爾等。下遊主要為(wéi)數(shù)據中心的使用(yòng)者,包括三家電信運營(yíng)商,百度、阿裏巴巴、騰訊、京(jīng)東等互聯網企業,數據港、光(guāng)環新網等第三(sān)方IDC服務商以及政(zhèng)府、科研(yán)機構、金融、能源(yuán)、交通等其(qí)他信息化需求客戶。

產業鏈(liàn)存在較高的技術、人才、客戶認證壁壘。

1)技術壁壘(lěi):液冷數據中心基礎設(shè)施產品(pǐn)的研(yán)發和製造涉及(jí)冷卻技術、製冷係統設計及仿真技術、溫濕度解耦控(kòng)製算法(fǎ)等多項(xiàng)技術領域,要求企(qǐ)業在液冷核心(xīn)技術進行多年研究積累,深入掌握液冷技術的相關原理(lǐ)和應用。此外,液(yè)冷數據(jù)中心基礎設施產(chǎn)品工藝流程複雜,需要掌(zhǎng)握生產製造流程中的(de)核心工藝,同時需具備成熟的控製體係,對產品質量進行把控,保證產品的(de)合格率,因此數據(jù)中心液冷行業具有(yǒu)較高的技(jì)術壁壘。

2)人才壁壘:液冷數據中心基礎(chǔ)設施領域屬於新興技術密集型產業,產品性能涉及材(cái)料化學、熱(rè)力學、電子學(xué)、計(jì)算機(jī)科學等多學科,並且數據中心(xīn)的製(zhì)冷係(xì)統存(cún)在定(dìng)製化特征,因此對研發技術人員的技術研發能力和行業經驗要求較高。目前行業發展曆程較短,技術與產品仍(réng)處於驗證階段,高端技術人才相對稀(xī)缺,且高端人才主要集中規模較大的企(qǐ)業以及***研(yán)究機構中,因此新(xīn)進企業難以在(zài)短期內培養出一批具備技(jì)術開發實力並擁有豐富(fù)實踐項(xiàng)目(mù)經(jīng)驗的專業技術隊(duì)伍(wǔ),由此數據中心(xīn)液冷行業存(cún)在較高的專業人才壁壘。

3)客戶認證壁壘:出於安全性、穩定性等考慮,企業客戶在選(xuǎn)擇液冷數據中心(xīn)基礎設施供應商時通常需要進行嚴格的資質驗證。尤其是金融、醫藥等機構(gòu)出於數據安全、保密等要(yào)求,對(duì)液冷數(shù)據(jù)中心基礎設施解決方案供應商挑選非常嚴格,需要對企業產品質量水平、項(xiàng)目(mù)經驗、技術研發能力進行綜合考察,因此認證過程複雜且(qiě)耗時較長。液(yè)冷數據中心基礎設施(shī)廠商應具備較強的產品研發能力、穩定的產品供應以及(jí)售後服務經驗,同時具備豐富的技術儲備,才能滿(mǎn)足不同(tóng)客戶的需求。另一方麵,由於更(gèng)換液冷(lěng)數據中心(xīn)基礎設施(shī)供應商會對產品的穩定性形(xíng)成風險,客戶在與液冷數據中心基(jī)礎設施供應商建立生產配套(tào)關係後,傾向於維持與現有技術供應(yīng)商的合作,不會輕易(yì)更換主要(yào)供應(yīng)商,因此先進入(rù)者(zhě)一(yī)旦建立起自身客戶資源、形成(chéng)先發(fā)優勢,新進入企業將很難在短期內爭奪市場份(fèn)額、改變行業現有格局,因此數據中心液冷行業具有(yǒu)較高(gāo)的(de)客戶認證門檻。

2.3 競爭格局:行業仍處於技術驗證階段,市場格局尚不明確

目前液冷行業仍處於技(jì)術驗證階段(duàn),技術(shù)路線、產品結(jié)構、行業標準(zhǔn)等(děng)還無定數,國外廠商(shāng)難以(yǐ)進入中國市場,市場競爭格局尚不明確。目前市場中主要廠商在(zài)液冷技術和產品(pǐn)方麵還處於實驗研(yán)究(jiū)或初步應用階段,產品結構與行業標準尚在演進,市場內還未(wèi)形成具備較強核心競爭力的龍頭廠商,市(shì)場競爭格局尚未穩(wěn)定。此外,由於中國對(duì)數據安全的保護,在(zài)數(shù)據中心基礎設施的供應方麵存在(zài)一定的地域壁(bì)壘,因此,目前國外廠商的產品(pǐn)的應用主要以其本國市場為主,進入中國市(shì)場較為困難。

3 數據中心液冷行業未來看點

3.1 推(tuī)理/訓練服務器功耗有(yǒu)望達到10/2kW,液冷方案成為(wéi)首選

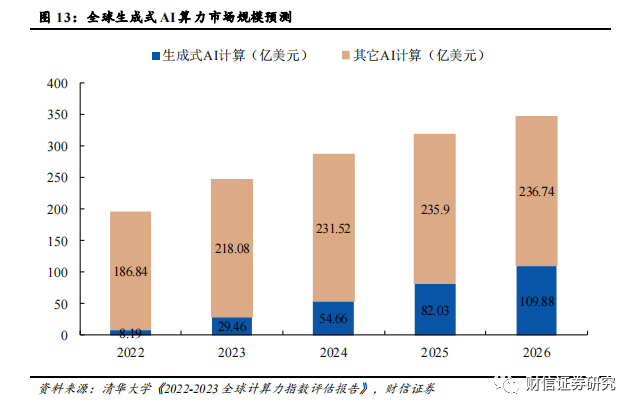

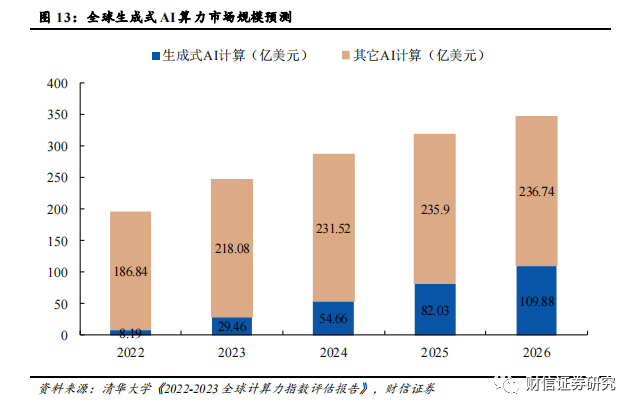

生成式(shì)人工智(zhì)能橫空出世,助推AI算力景氣度。受ChatGPT為代(dài)表的生成(chéng)式人工智能大模型等新業態帶動,全新的AI應用場景有望在未來3-5年(nián)爆發,百億(yì)參數是大模型具備湧現能力的門檻,千億參數的大模型將(jiāng)具備較好的湧現能力,AI算力成為大(dà)模型能力提升的核(hé)心驅動力。現階段ChatGPT的總算(suàn)力消耗達到了3640PF-day(每(měi)秒(miǎo)計算一千萬億次,需要計算3640天),需要7-8個投資規模(mó)30億元,算力500P的超大數據中心才能支撐其訓練(liàn)過程,AI算力的重要性不言而喻。據IDC預測(cè),全球AI算力市場規模將從2022年的195.0億美元增長到2026年的346.6億美元,其中生成式AI算力(lì)市場規模將從(cóng)2022年的8.2億美元增長到2026年的109.9億美元,生成式AI算力占整體AI算力市場規模的比例將(jiāng)從4.2%增長到31.7%。

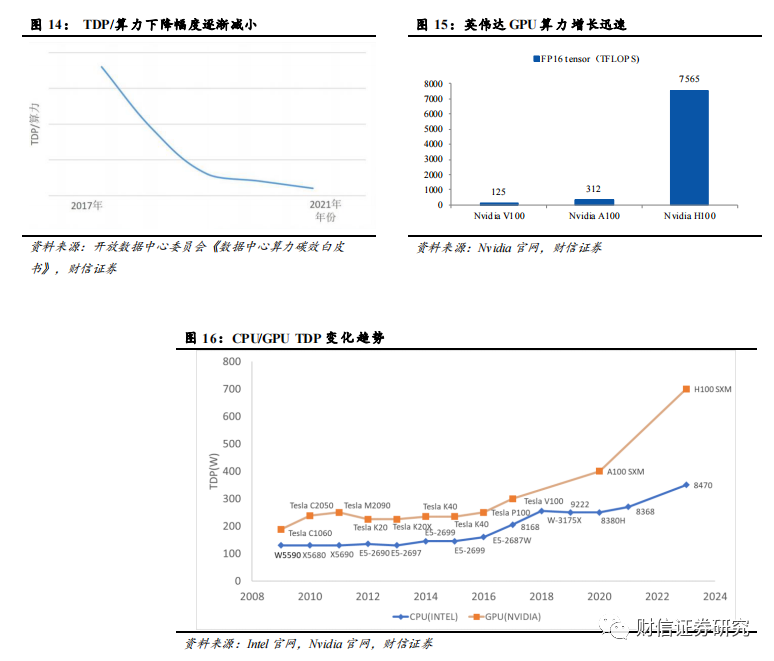

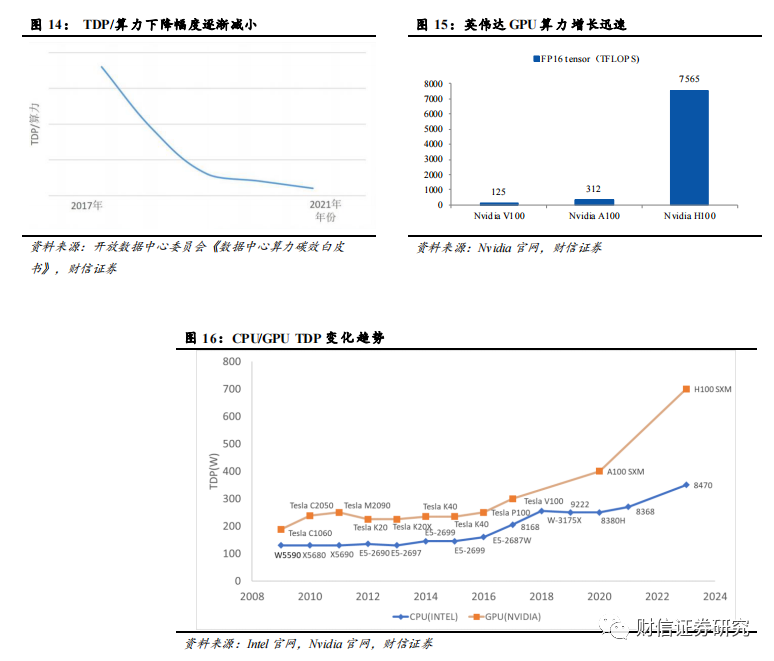

大模型帶來高算(suàn)力,高(gāo)算力帶來高功耗。隨著(zhe)AI計算、HPC計算等高性(xìng)能計(jì)算需求不斷(duàn)提升,CPU、GPU等計算芯片朝高算力、高集成方向演進,同時也導致單(dān)顆計算芯片功耗的大幅提升。對於CPU、GPU、ASIC等計算芯片而言,一方麵可以(yǐ)通過(guò)增加計算核心數(shù)或提高單核心的主頻等方式來提高算力,此舉會顯著增加芯片的TDP(熱(rè)設計功耗(hào));另一方(fāng)麵可以依靠先進製程技術來縮減單位算力對應的TDP(TDP/算力)。但是由於先(xiān)進(jìn)製程技術推進較慢等(děng)因素,單位算力對應TDP的下降幅度逐年減少,且遠不及算力的增長速度(dù),這也導致了AI芯片功耗的大幅攀升。當前,Intel的多款CPU芯片的TDP已突破(pò)350W,NVIDIA 的H100係列GPU芯片的TDP更高達700W。

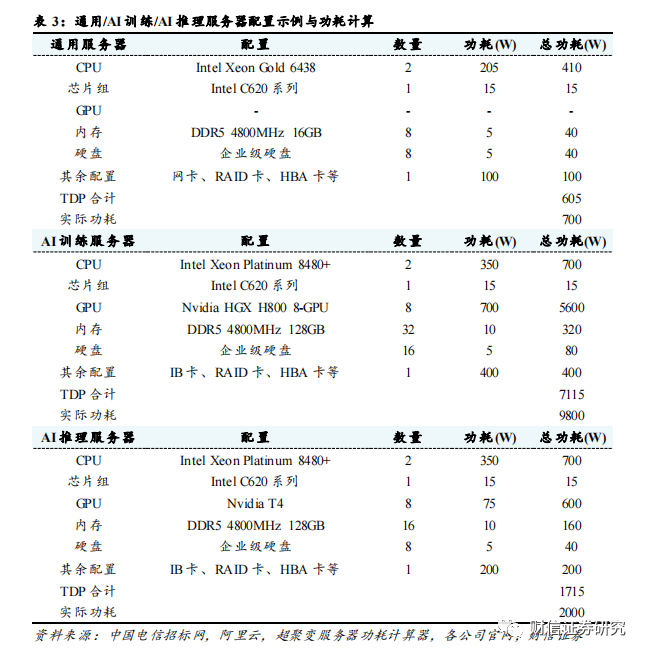

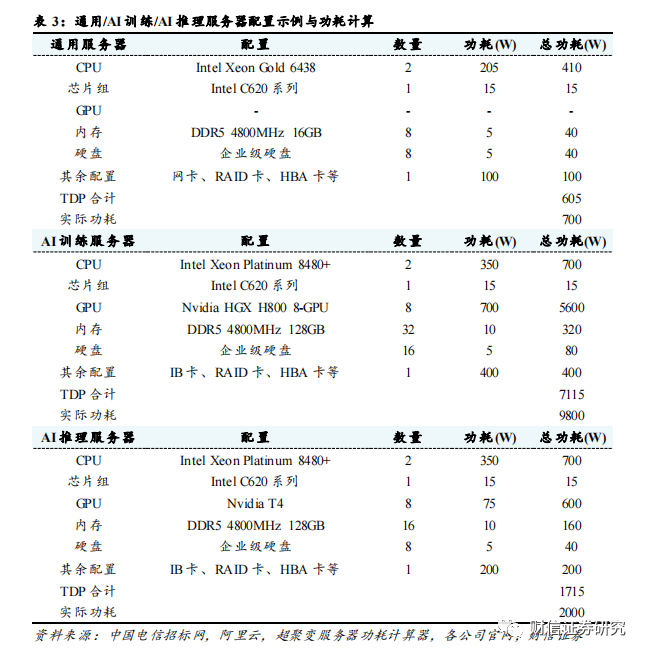

計算芯片高功耗造成單服務器功耗顯著提高。單服(fú)務器功耗大部分源於計算芯(xīn)片,服務器的核心組件包括CPU(中央處理器)、GPU(圖形(xíng)處理器)、內存芯片、SSD(固態硬盤(pán))、網卡、PCB主板、RAID卡、HBA卡和電(diàn)源等。CPU/GPU等計算芯片在通用(yòng)服務器功耗中占比約為50%左右,而在AI服務器中,計算(suàn)芯片的功(gōng)耗占比高達80%以上。我們參考2022-2023年中國電信集采AI服務器配置與阿(ā)裏雲通用服務器(qì)配置進行功耗計(jì)算,服務器的功耗可以粗略估計為所有(yǒu)組件的功耗總和;選(xuǎn)取超聚變FusionServer 2288 V7作為通用服務器的代表(biǎo)型號(hào),超聚變FusionServer G5500 V6作為AI訓練服務器的代(dài)表型號,超聚變FusionServer G8600 V7作為AI推(tuī)理服務(wù)器的代表型號。

通(tōng)過(guò)我們的測算,通用服務器的總功耗為595W,AI訓練服務器的總功耗為7015W,AI推理服務(wù)器的總功耗為1615W。但是由於芯(xīn)片超頻,額(é)外的NVLINK模組等因素的存在,計算芯片的實際滿載功耗往(wǎng)往會(huì)高於官方標定的功耗(hào)。以上(shàng)因素導致服(fú)務器的實際(jì)功耗(hào)可能會高於各組件的總功(gōng)耗,具體的功(gōng)耗還要以實際測試為準。根據超聚變服務器功耗計算(suàn)器的(de)測算,當前配置下的通用服務器的實際滿載功耗為700W左右,AI訓練服務器的實際滿載功耗為9800W左右,AI推理服務(wù)器的實際滿載功耗為2000W左右。(該過程僅為根據公開資料的估算,請以實際環境和負載下的(de)測算(suàn)為準)

隨著服務器功耗提高,單機櫃(guì)功(gōng)率(lǜ)上升趨勢明顯。根據Uptime Institute相關(guān)報告數據顯示,2020年全球數(shù)據(jù)中心單機櫃功率密度達到8.4kW/機櫃,相比於2017年的5.6 kW/機櫃(guì)有明顯提升;其中71%的數據中心平均功率密度低於10 kW/機櫃,17%的數據中心平均功率密度高於(yú)20kW/機櫃,預(yù)計未來數據中心功率密度將繼續上升,高(gāo)密度數據中心占比將持續提高。

單機櫃功率逐漸超出風冷散(sàn)熱閾值(zhí),液冷(lěng)散熱已是趨勢所向。風冷散熱一般適用於20Kw/機櫃左右的功率密(mì)度以下(xià),20Kw/機櫃以上時液冷(lěng)散熱優(yōu)勢明顯。通用服務器通常為2U,AI訓練服務器(qì)通常為6U,AI推理服務器通常為4U,標準機櫃為42U;考慮到電源模塊、網絡(luò)模塊等(děng)因素,假設單機櫃內可以放置18個通用服務器或6個AI訓練服務器或(huò)9個AI推理服(fú)務器,根據之(zhī)前對於(yú)服務器功(gōng)耗的測算,則單機櫃功率可(kě)以分別達到(dào)12.6kW(通用),58.8kW(AI訓練)和18kW(AI推理);考慮到機櫃中其他模塊的(de)散熱情況,實際單機櫃功率會更高。對於(yú)通用服務器機櫃,其單機櫃功率已經開(kāi)始逐步靠近風冷散熱閾值,隨著通用服(fú)務器功耗的持續(xù)上升,液冷散熱的優勢有望(wàng)逐(zhú)步顯現;對於AI訓練與推理服務器機櫃,其(qí)單機櫃功(gōng)率已經逼近或者超出了風冷散熱所能(néng)覆蓋的功率密度範圍,液冷散(sàn)熱已成(chéng)大勢所趨。

3.2 PUE限製是現階(jiē)段液冷技術發展的核心驅動力

數據中心耗電量不斷提升,綠色低碳成為必(bì)然趨勢。數據中心是能耗(hào)大戶,其包含大量的(de) IT 設備、供電與製冷設備。隨著數據中心算力與功耗的不(bú)斷增長(zhǎng),數據中心耗電量必將呈快速增(zēng)長趨勢,綠色低(dī)碳(tàn)必將並且已經成為新型數據中心發展的重要基本原則之一。

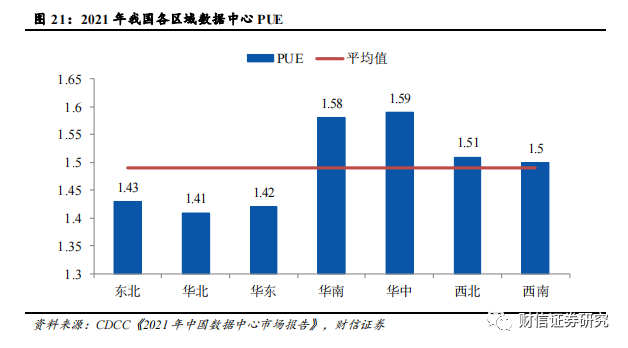

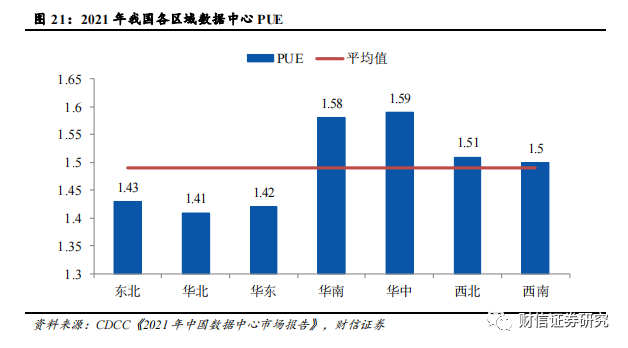

我國數據中心(xīn)平均PUE為1.49,仍有(yǒu)半數(shù)區域的數據中心PUE位(wèi)於1.5以上。PUE 全稱 “Power Usage Effectiveness(能源使(shǐ)用效率)”,是數據中心消耗的一(yī)切能源與 IT 負載運用的能源之比,比值越接近於1,說明能源越接近(jìn)全(quán)部都用於 IT 負載上。目前我國一半以上區域的數據中心 PUE 值(zhí)都在 1.5 以上,即(jí)消(xiāo)耗在(zài)冷卻等非 IT 負載上的能(néng)源,占到了 IT 負載的一半(bàn)以上。截至(zhì)2021年全國數據中心平(píng)均PUE為(wéi)1.49,還有華南、華東、西北和西南區域的數據中心PUE超(chāo)過1.50,僅有東北、華北和華東區域的數據中心PUE在1.50以(yǐ)下。

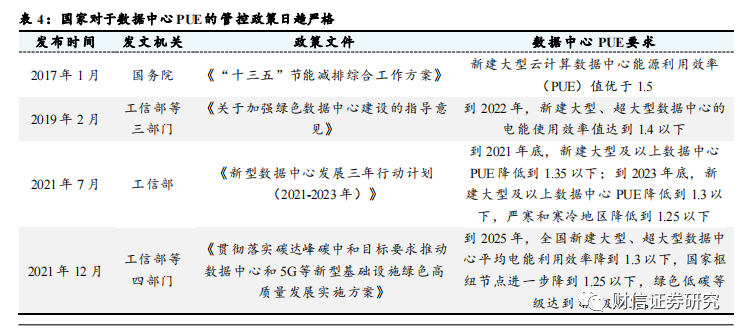

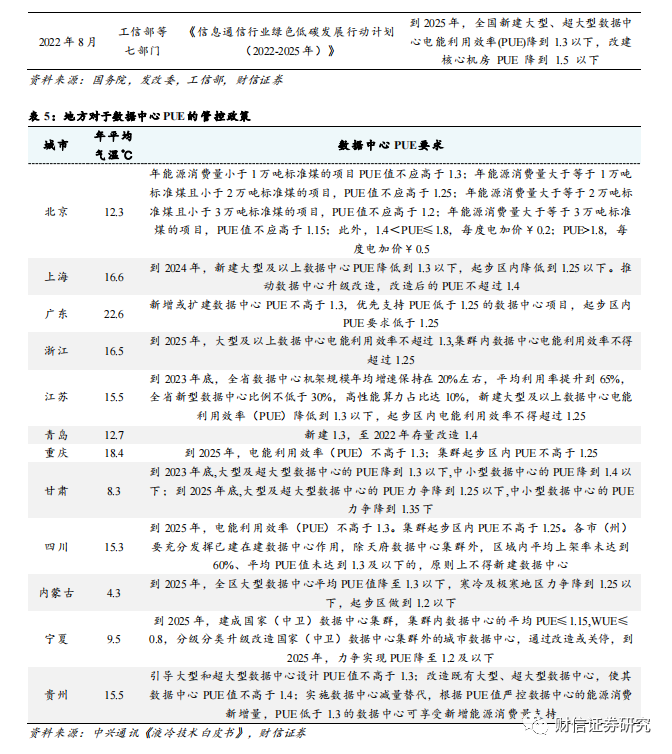

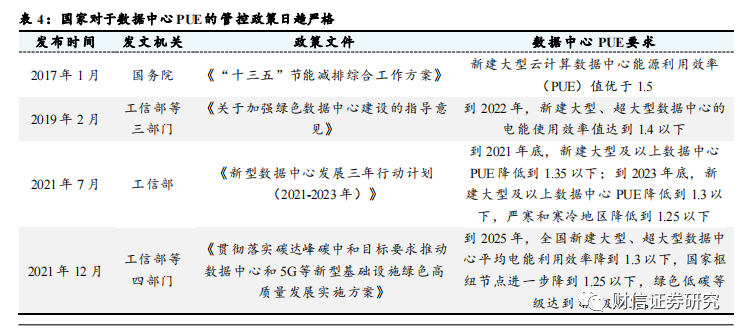

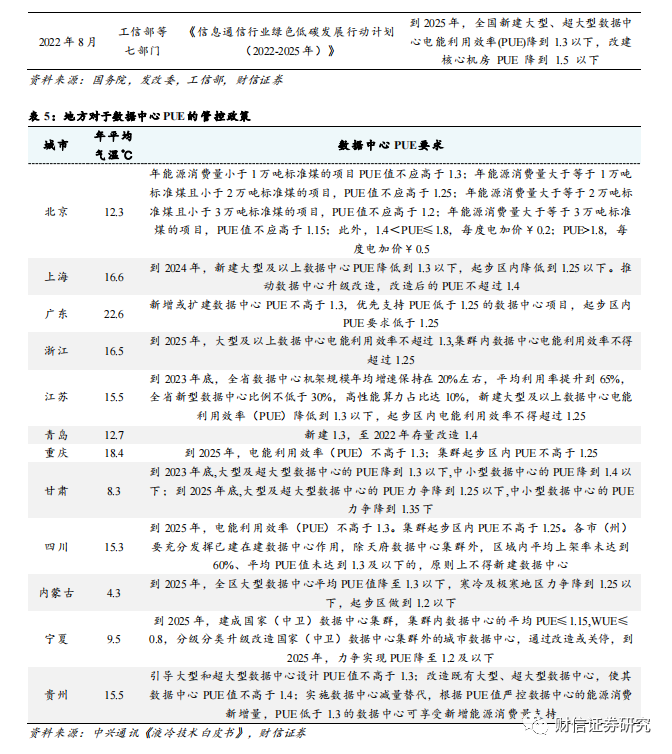

數據(jù)中心PUE管控日趨嚴格(gé),針對老舊與新建數據中(zhōng)心均出台強力約束措施。國家與地方出台了一係列政策對數據中心能耗管理進行(háng)規範,不斷強調數據中心綠色(sè)高質量發展的重要性。2021年7月,工信部印發(fā)《新型數據中心發展(zhǎn)三年行動計劃(2021-2023年)》,要求到2021年底,新建大型及以上數據中心PUE降低到1.35以下;到2023年底,新建大型(xíng)及以上數據中心PUE降低到(dào)1.3以下,嚴寒和寒冷地區降低到1.25以下。2022年8月,工信部等(děng)七部門印發《信(xìn)息通信行業(yè)綠色低碳發展行動計劃(2022-2025年)》,要求到2025年,全國新建大型、超大型數據中心電能利用效率(PUE)降到1.3以下,改建核(hé)心機房PUE降到1.5以下。除此之外,地方也出台了一係(xì)列數據中心PUE要求相關的政策文件,其中北京針(zhēn)對數據中心的年能源消耗量設立了多層次PUE要求,年能源消耗量越高的數據(jù)中心PUE要求越高,此外還(hái)針對PUE超過1.4的(de)數據中心實行電價加價措施。

冷卻係統占據數據中心除IT設備負載外的能耗中的絕大部分,液冷技(jì)術能夠(gòu)有效降低冷卻(què)係統能耗,進而降(jiàng)低數據中心PUE,滿足監管政策要求。PUE為1.92的數據中心下冷(lěng)卻係統能耗占總能耗的比例為38%左右,而PUE為1.3的(de)數據(jù)中心下(xià)冷卻係統能耗占比下降至18%,這意(yì)味著降低數據中心PUE的關鍵就在(zài)於降(jiàng)低冷卻係統的能耗表現(xiàn)。在同等的散熱水(shuǐ)平下,傳統風冷方案的數據中心PUE一般為1.5左右,液冷方案的PUE值可降至1.05-1.2左右,能夠滿足當前政策對於數據中心PUE的要求。

3.3 數據中心TCO是液冷技術規模(mó)應(yīng)用(yòng)的關鍵因素(sù)

數(shù)據中心總成本(TCO)包括建設(shè)成本(Capex)和運(yùn)營成本(Opex)。Capex一般指(zhǐ)建設成(chéng)本,包括土地獲取、勘察、規劃設計、設備購置(zhì)、建設(shè)、安裝以及係統調(diào)測等費用;Opex一般指運營(yíng)成本,主要包含電力、冷卻散熱(rè)等基礎設施成本、維護成(chéng)本及管理(lǐ)成(chéng)本。低成(chéng)本是數據中心建立競爭優勢的關鍵,也是降低投資回(huí)收期和持續(xù)發展的關鍵。

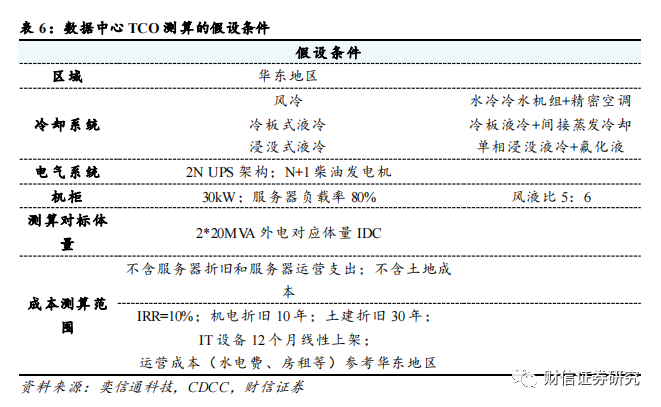

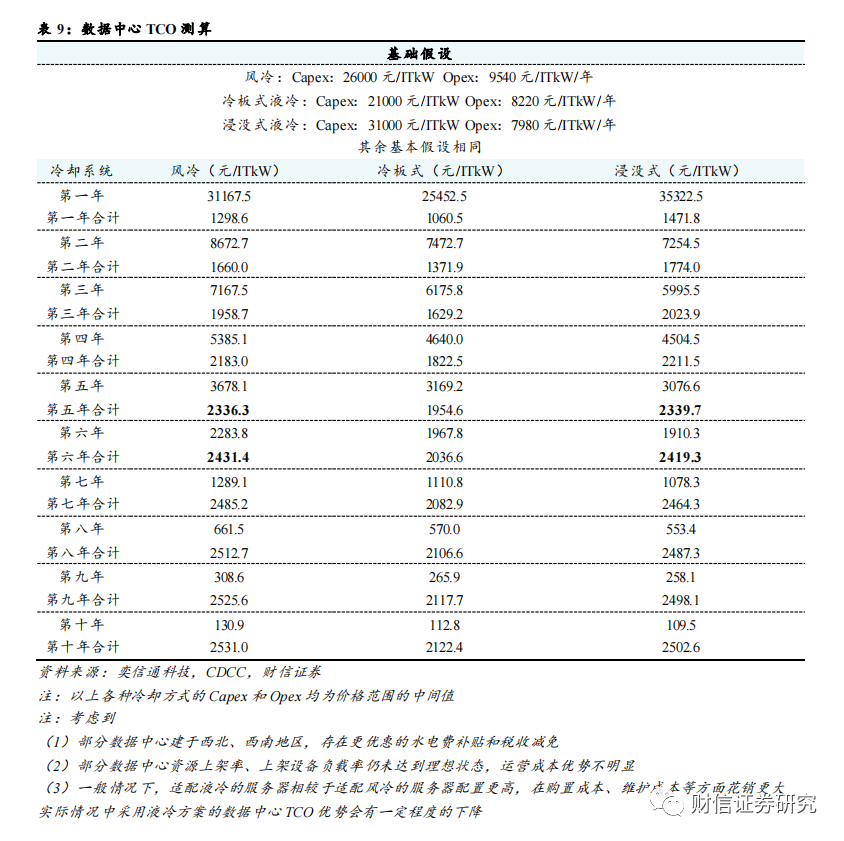

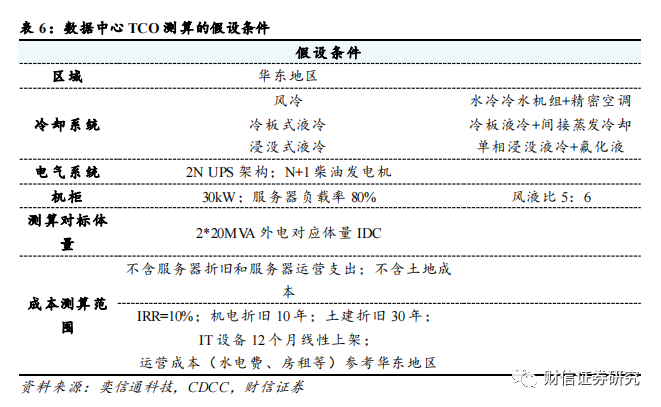

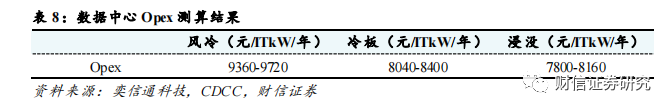

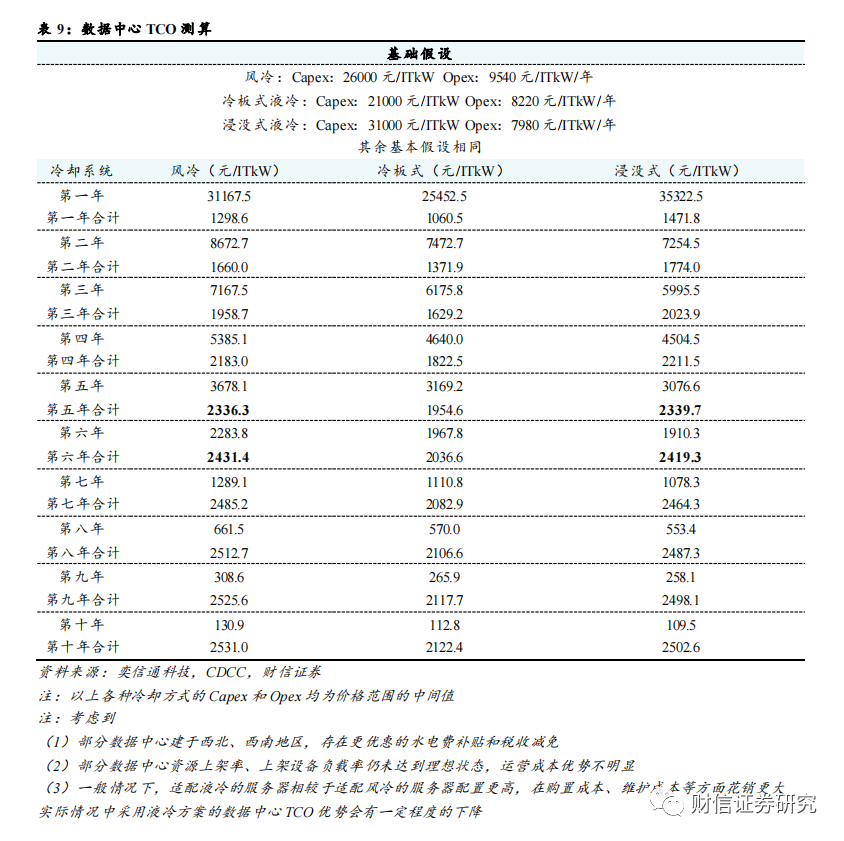

我們基於華東地區、2N UPS、30kW每機櫃等常見數(shù)據中心配置進行風冷、冷(lěng)板式液冷和(hé)浸沒式液冷等不同(tóng)冷卻方式下的(de)TCO測算(suàn)(本文關(guān)於TCO的討論均不(bú)考慮服務器等IT設備成本)。市場普遍認為,風冷(lěng)方(fāng)案在Capex上(shàng)更具經濟性(xìng),液冷方案隻在後(hòu)續的Opex中(zhōng)有一定(dìng)的優勢。但是根據奕信通科技在2022年數據中心標準峰(fēng)會(huì)(CDCC)發(fā)布的報告進行(háng)測算(suàn),現階段選(xuǎn)擇冷板式液冷方案的Capex已經低於風冷方案(àn),即便是浸沒式液冷方案,也將在(zài)運行5年左右之後出現TCO低於風冷方案的拐點。(該過程僅為根據公開資料的估算,請以實際環境和負(fù)載下的測算為準)

但是該測算結果依賴於一(yī)定的前提條件:如機櫃功率達到30KW、不計算服務器折舊和服務器運營支出、水(shuǐ)電費與房(fáng)租等運營成本按華東地區情況計價、采用集中(zhōng)式大型IDC機房且IT設備在12個月線性上架後實現80%負載(zǎi)率、外界氣溫對製冷係統的能耗需求較高(gāo)等。因此在西北部地(dì)區、較小型數據中心等場景下液冷(lěng)技術的(de)經濟性尚沒有完全體現。但在數據中心發展(zhǎn)的大型化、集(jí)約化的趨勢下,且(qiě)液冷(lěng)方案仍存在每(měi)年降本5-10%的空(kōng)間,再考慮到液冷方案能夠有效(xiào)延長服務器(qì)使(shǐ)用壽命,未來液冷數據中(zhōng)心TCO的優勢將更加(jiā)明顯。

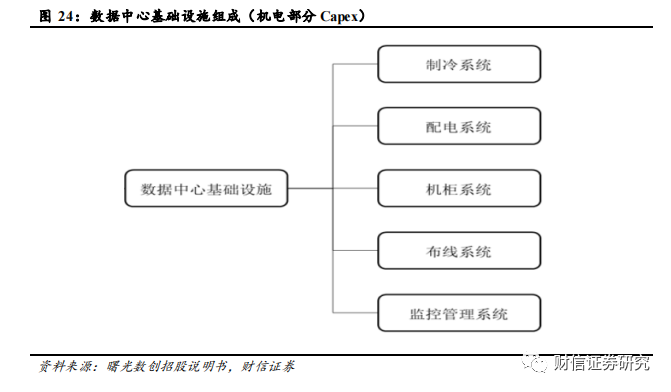

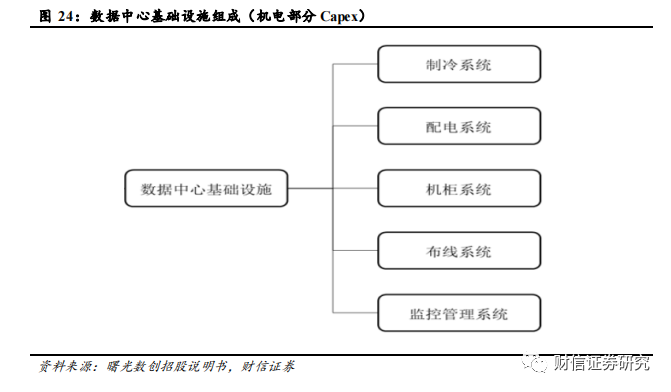

機電部分包括(kuò)製冷係統、配電係(xì)統、機櫃係(xì)統、布線(xiàn)係統和監控管(guǎn)理係統的購置和安裝(zhuāng)成本,不考慮(lǜ)IT設備成本。

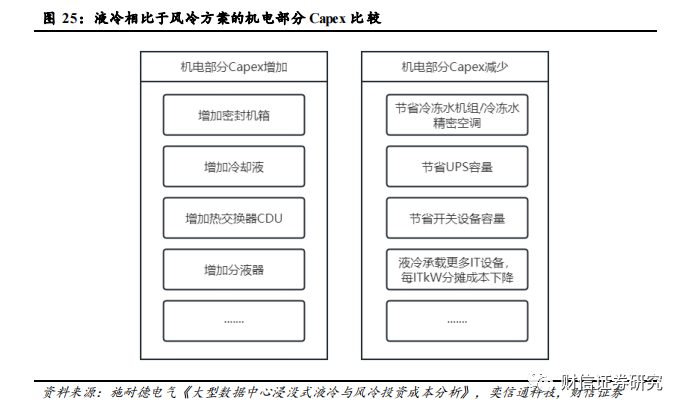

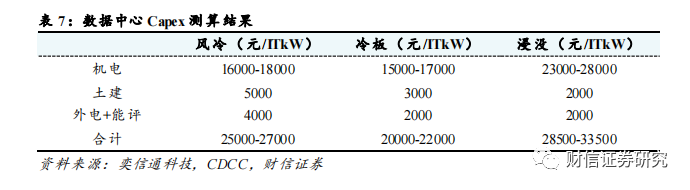

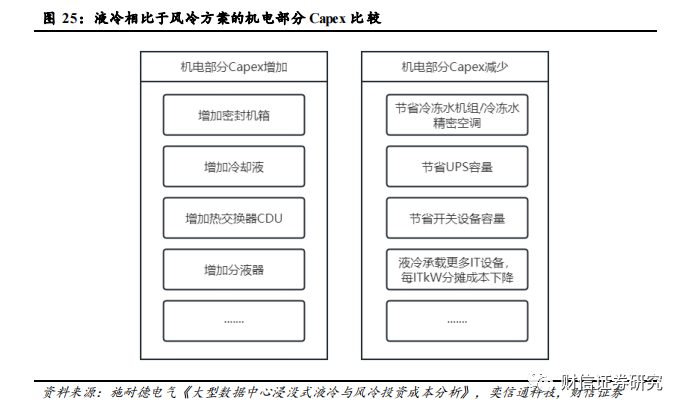

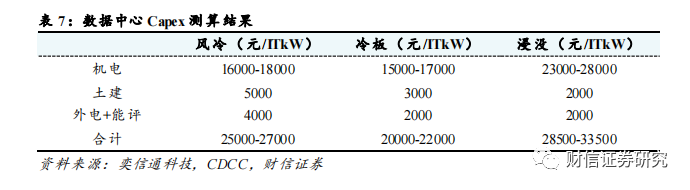

液冷(lěng)方案與風冷方案相(xiàng)比:1)其機(jī)電部(bù)分的Capex可以節省掉冷(lěng)凍水機組/冷凍水(shuǐ)精密空調,減(jiǎn)少(shǎo)UPS和開關設備的容量等;2)需要增加密封機箱、冷卻液、冷(lěng)板、熱交換器、防滴漏連(lián)接器和機架式分液器(qì)等液冷設備(bèi)方麵(miàn)的成本;3)液冷方案下同樣外電體量的數據中心內空(kōng)間利用率更高,能承載更多(duō)IT設備,每ITkW(IT設備功率)下的(de)分攤成本更低。根據假設條件測算,風冷、冷板式液冷(lěng)、浸沒式液冷方案的機電部分Capex分別為16000-18000元/ITkW、15000-17000元/ITkW和23000-28000元/ITkW左右。冷板式液(yè)冷方案下分攤到每ITkW下的機電部分Capex與風(fēng)冷方案基本持平甚至更低;浸沒式液(yè)冷(lěng)方案所需增加的機電設備較多,分攤下來每ITkW的Capex相比於風冷仍有7000-10000元/ITkW左(zuǒ)右的上升。

土(tǔ)建部分主要包括建築(zhù)物成本。風冷和液冷方案的(de)土建成本差異主要在於同樣體量的數據中心內,液冷方案下建築所需的建築麵積更小(xiǎo)。根據奕信通(tōng)科技測算,風冷、冷板式液冷、浸沒式液冷的土建部分Capex分別(bié)為5000元(yuán)/ITkW,3000元/ITkW和(hé)3500元/ITkW左右。

外電和能評部分主要(yào)包括獲取外電資源,通過能評驗收所需付出的成本。與風冷相比(bǐ),液冷方案的PUE更低更節能,獲(huò)取外電資源,通過能評驗收的難度(dù)相對(duì)會小很多。根據奕信(xìn)通科技測算,風(fēng)冷、冷板式液冷、浸沒式液冷的外電和能評部分Capex分別為4000元/ITkW,2000元/ITkW和2000元/ITkW左右。

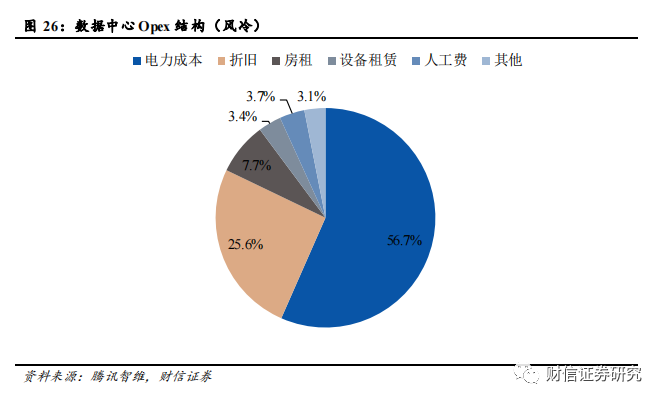

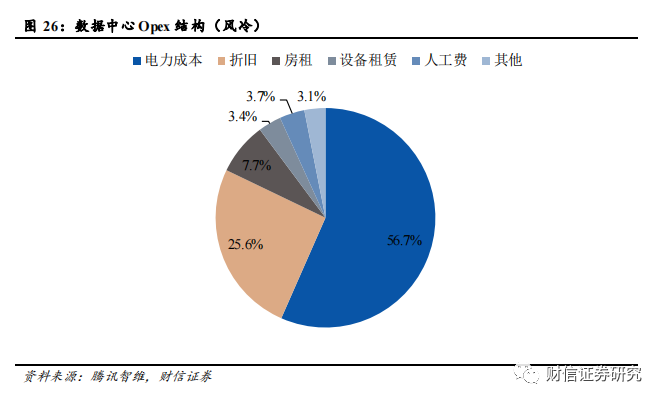

Opex中占比*高(gāo)的是電力(lì)成本,液冷技術可以(yǐ)有(yǒu)效降低電力成本。數據中心的Opex主要包括電力成本、固定資產折舊、房租、人工費等等(děng),其中電力(lì)成本占比*高(gāo),達到56.7%(風冷情(qíng)況下)。

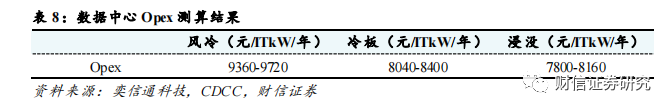

浸(jìn)沒式液冷方案的Opex*具優勢。根據奕(yì)信通(tōng)科技測(cè)算,風冷方案的Opex為9360-9720元/ITkw/年左(zuǒ)右,冷(lěng)板(bǎn)式(shì)液冷方案的Opex為8040-8400元/ITkw/年左右(yòu),浸沒式液冷(lěng)方案的Opex是7800-8160元/ITkw/年左(zuǒ)右。

現階段選擇冷板式液冷的初始TCO已經低於風冷,浸沒式液冷的TCO將在5-6年(nián)之後低於風冷。我們根(gēn)據以上測算結果進行10年期的TCO測算,那麽風冷的Capex和Opex分別為26000元/ITkW和9540元/ITkW/年,冷板式液(yè)冷的Capex和Opex分別(bié)為21000元/ITkW和8220元/ITkW/年,浸沒(méi)式液冷(lěng)的Capex和Opex分別為31000元/ITkW和7980元/ITkW/年。根(gēn)據TCO測算,現階段(duàn)冷板式液(yè)冷方(fāng)案的TCO從開始就已經低於風冷方案,浸沒式液(yè)冷方案也將在(zài)5年左右之後出現TCO低於風(fēng)冷方案的拐點。

3.4 液冷技術能夠有效延長服務器使用壽命,實(shí)現降本增效

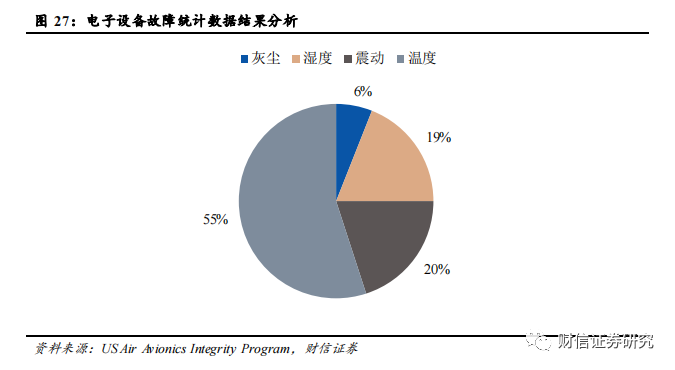

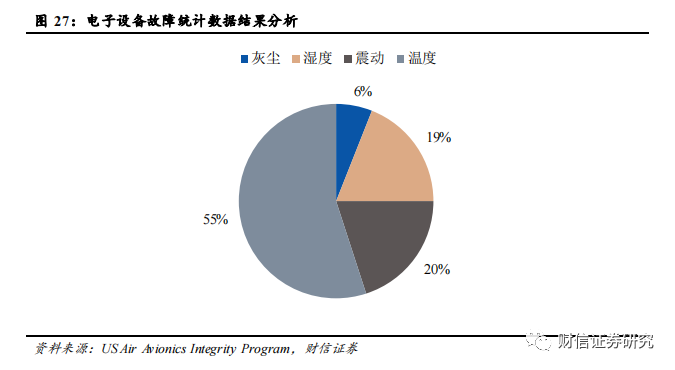

傳(chuán)統電(diàn)子設備普遍采用空氣冷卻方式,溫度是電子設備產(chǎn)生故障的主要原因之一。環(huán)境的多樣性包括溫度、濕度、振動、灰塵等多(duō)個方麵,在導致電子設備失效的因素中溫度占了55%,過熱是電子設備產生故障的主要(yào)誘(yòu)因。隨著(zhe)溫度(dù)的增加,電子、原子、分子的運動速(sù)度加快,使得電子設備的性能發生變化,當達到一定階段時(shí),就會引起嚴重(chóng)的故障。在高於一般室內環境溫度(約20°C~25°C)範圍內條件下,故障率大致按指數規律隨溫度的升(shēng)高(gāo)而增(zēng)加。同時,濕度、振動、灰塵等因素同樣會(huì)對電子設備的工作性能和使用壽命產生負麵影響。

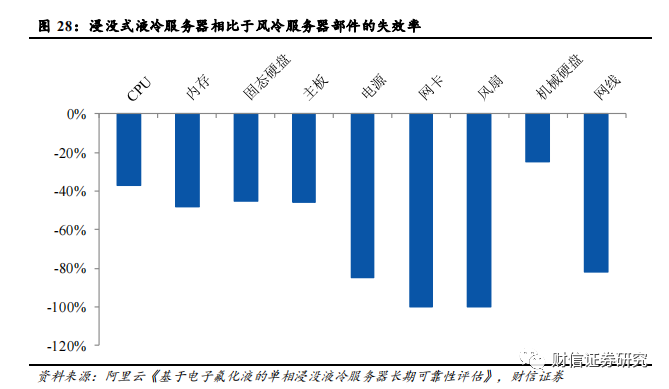

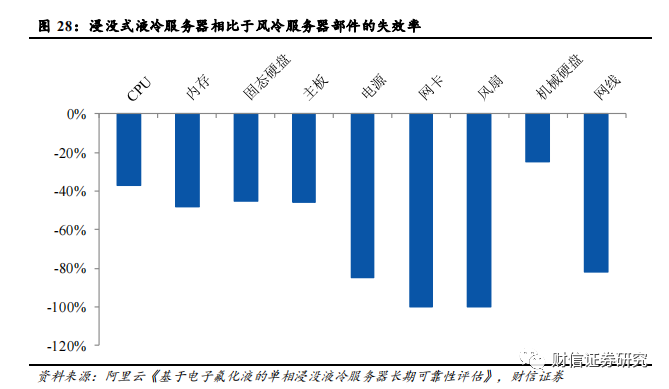

液(yè)冷能夠有效降(jiàng)低服務器部件故障率,延長使用壽(shòu)命。液體具有比空氣(qì)更大的(de)比熱容,散(sàn)熱能力(lì)更強,使得服務(wù)器(qì)溫度更加穩(wěn)定,CPU和GPU計(jì)算部件可以長時間穩定(dìng)工作在高(gāo)性能頻率狀態。此外,浸沒式液冷將IT設備浸入封閉的液體環(huán)境中,與空氣完全隔離,並且不再需要高速風扇進行散熱(rè),消(xiāo)除(chú)了空氣濕度、風扇振動以及灰塵帶(dài)來的可靠性影響,從而優化了服務器的運行環境,延長(zhǎng)了設備的使用壽命。根據阿裏雲的實驗數據,與風冷服務(wù)器(qì)相比,液冷服務器整體部(bù)件故障率下降約53%,其中電源、網卡、風扇、網(wǎng)線等部件的故障率下降超過80%。隨著(zhe)單服務器價(jià)值量以及數據中心運營成本的與日俱增(zēng),服務器(qì)的可靠性與使(shǐ)用壽命顯得尤為重(chóng)要,液冷帶來的附加經濟價(jià)值有望(wàng)逐步顯現。

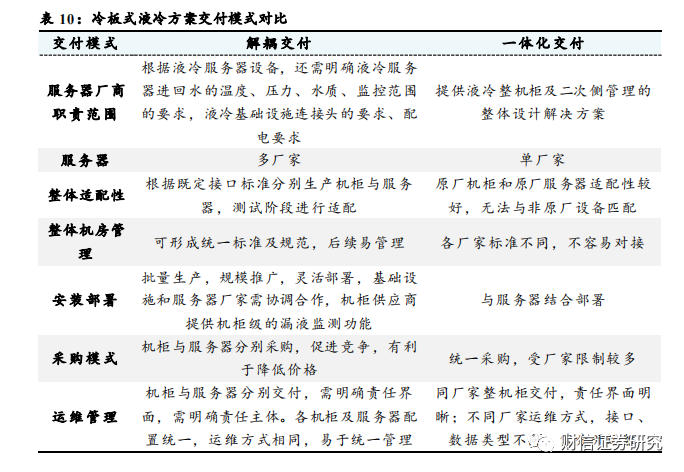

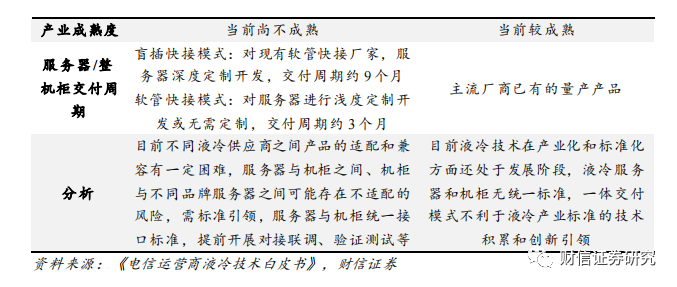

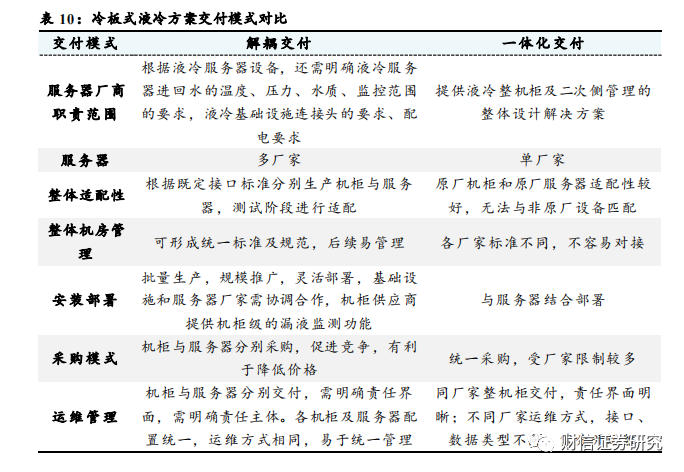

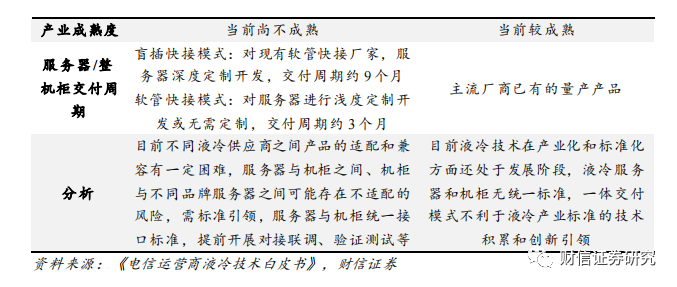

3.5 解耦交付模式(shì)成為未來發展趨勢,助力液冷產業規範化發展

目前冷板式液冷方案的(de)交付模式可以分為兩類,包括一(yī)體化交付與解耦交付兩種(zhǒng)。一體化交付(fù)是指液冷機櫃的所有部分,包括機櫃和服務器(qì)等,都按(àn)照(zhào)廠商自行設定的標準進行集成設計開發,然後再作(zuò)為一個整體進行(háng)交(jiāo)付。而解耦交付則要(yào)求液冷機櫃與液冷服務器之間遵循用戶(hù)預先製定的通用接口設計規範,機櫃(guì)與服務器(qì)可以分別由不同廠商負責生產和交付。

解耦交付模(mó)式為大勢所趨,助推冷板式液冷產業規範化發展。服務(wù)器與機櫃解耦更有利(lì)於形成統一的技術標準及規範,能夠促進行業競爭與技(jì)術推(tuī)廣,讓更多廠商能夠參與液冷行業,實現多廠家適配,也便於後續(xù)靈活部署,使得客戶可以根據實際需求選擇不同的服務器和機櫃組合,不會受限於某一個供應商。目前華為、超聚變等液冷廠商(shāng)已經(jīng)實現了盲插快接(jiē),中國移動也已經著手研發新型機櫃,並計劃在完成(chéng)測試後(hòu)開源,推動更多的服務器和機櫃廠商參與到盲插(chā)解耦液(yè)冷(lěng)技(jì)術的研發與驗證中(zhōng),推動技術成熟與規範化。

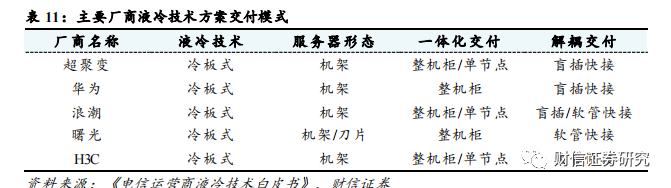

4 數據中心(xīn)液冷(lěng)未來市場規模估算

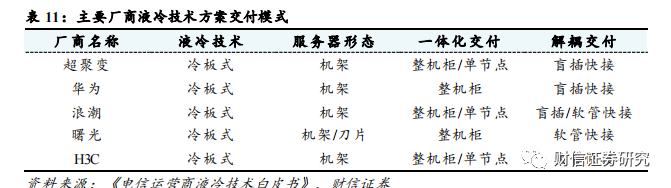

根據估算,到2025年,中國數據中心液冷市場規模將達到359億元左右,CAGR達到72.4%;AI數據(jù)中心液(yè)冷市場規模將達到280億元左右,CAGR達到71.4%;通(tōng)用(yòng)數據中心液冷市場規模將達到79億元,CAGR達到76.2%。核心假設如下:

1)假(jiǎ)設通用服務器的(de)平均(jun1)功率為0.7kW。以超聚變FusionServer 2288 V7(2U)作為通用(yòng)服務器的代表型號,在超聚變服務器功耗計算器中測算得出其滿(mǎn)載功率約(yuē)為0.7kW。

2)假設AI服務器的平均功率為3.8kW,其中AI訓練服務器平均功率為8kW,AI推理服務器為2kW。根據(jù)產業調研數據,假設(shè)AI服務器(qì)中(zhōng)訓練與推理的數量關係約(yuē)為(wéi)3:7,訓練服務器中H係列和A係列所占比例約(yuē)為4:6,推理(lǐ)服務器(qì)均為T4係列。以(yǐ)超聚變FusionServer G5500 V6作為AI訓練服(fú)務器的代(dài)表型號,超聚變FusionServer G8600 V7作為AI推理(lǐ)服務器的代表型號,根據超聚變服務器功耗(hào)計算器,H係列訓練服務器滿載功率約為10kW,A係列訓練服務器滿載功率(lǜ)約為6.8kW,T4係列推理服務器的功率約為2KW。結合以上數量比例關係,可以估算出AI服務器平均功率約為(wéi)3.8kW。

3)假設通用服(fú)務器平均功率每年提升10%,AI訓(xùn)練與推理服務器平均功率未來三年提升30%/20%/15%。根(gēn)據近幾年(nián)CPU/GPU TDP的變化趨(qū)勢(shì),CPU TDP每(měi)年提升10%左右,GPU TDP每年提升20%左(zuǒ)右,我們假設通用服務器平均功率未來三年保持10%左右的增速,AI訓練與推理服務器平均功率未來三年的增速為30%/20%/15%。

4)至2025年,假(jiǎ)設通用(yòng)服務器液冷(lěng)滲透率由5%提升到20%,AI訓練服務器(qì)液冷滲透率由70%提升到100%,AI推理(lǐ)服務器液冷滲透率由40%提升(shēng)至70%。根據產業調研與曙光(guāng)數創的信息,2022年我國液冷滲(shèn)透率為5%-8%左右,預計2025-2028年時液冷滲(shèn)透率能達到30%左右。我們假設通用服務器(qì)2022年液冷滲透率為5%,至2025年液冷滲透率上升至20%;AI訓練服務器2022年液(yè)冷滲透率為70%,至2025年液冷(lěng)滲透率上升至100%;AI推理服務器2022年液冷滲(shèn)透率為40%,至(zhì)2025年液冷滲透率上升至70%;整體液冷滲透率由2022年的8%上升至(zhì)2025年的25.7%。

5)至2025年,假設浸(jìn)沒式液冷滲透率由10%提升至30%,冷板式液冷滲(shèn)透率由90%降低(dī)至70%。根據IDC《中國半年度液(yè)冷服(fú)務器市場(2023上半年)跟蹤》報告,按照服務器出貨量口徑統計,2023H1我國冷板式液冷服務器比例為90%左右,浸沒(méi)式液(yè)冷滲透率僅為10%。隨著未來浸沒式液(yè)冷技術逐漸(jiàn)成熟進入加速(sù)推廣(guǎng)期,我們預計浸沒(méi)式液冷的滲透率由2022年(nián)的10%上升至2025年的30%,冷板(bǎn)式液冷的滲透率(lǜ)由2022年的(de)90%下降至70%。

6)考慮到大部(bù)分數據中心液冷(lěng)廠商的產品隻覆蓋數據中心液冷(lěng)基礎設施中的製冷係(xì)統、機櫃係統等核心部分,故估算數據中心液冷市場規(guī)模時隻考慮數據中心液冷基礎設施中製冷係統(tǒng)、機櫃係統等核心部分的市場(chǎng)規模,不考慮布線係統、土建、外電、能評等其他配套部分。結合產業調研數據(jù),假設冷(lěng)板式(shì)液(yè)冷基礎設施的價值量約為10000元/ITkW,浸(jìn)沒式液冷基礎設施的價值量(liàng)約為15000元/ITkW。

7)考慮到未來數據中心液冷市場(chǎng)競(jìng)爭逐步加(jiā)劇以及技術逐漸成熟,液冷方(fāng)案價格將(jiāng)呈逐年(nián)下降的趨勢;冷板式液冷技術(shù)目前更為成熟,未來價格的下降空間相對較小。我們假設(shè)冷板式液冷價值量逐年下降5%,浸沒式液冷價值量逐年(nián)下降10%。

[聲(shēng)明]文章係本網編輯轉載,轉載目的在於傳(chuán)遞更多行(háng)業新聞(wén)信息,文章僅作交流學習使用(yòng),也並不代表本網讚同其(qí)觀點和(hé)對其真實性負責。如涉及作品內容、版權(quán)和其它問題,請在30日內與本網聯係,我們將在**時間刪(shān)除內容!

本站(zhàn)文章版權歸原(yuán)作者(zhě)所有 內容為作者個人觀(guān)點 本站隻提供參考並不構成任何投資及應用建議。本(běn)站擁有對此聲明的*終解釋權。

0519-82989061

0519-82989061